在 AI 技術與相關產品高速發展的時代,大量用戶隱私未經同意而被用於 AI 機器學習中,危害用戶隱私安全。而 國內外 AI 巨頭也意識到這一點,並積極用 AI 技術制定出保護隱私安全的產品。

一、隱私

我們處在一個智能變革的時代,人工智慧技術正在「賦能」各行各業。大數據就像新能源, AI 演算法就像發動機,裝載了大數據和人工智慧技術的企業就像搭上了一班通往未來的快速列車,把競爭對手遠遠地甩在後面。

然而,這樣的快速發展不是沒有代價的——

我們每個人的手機號、電子郵箱、家庭地址和公司地址經緯度坐標、手機識別碼、消費記錄、APP使用記錄、上網瀏覽記錄、搜索引擎結果的點擊習慣、刷臉記錄、指紋、心跳等等這些信息都是我們不願意輕易給出的隱私數據,但在 AI 時代,這很可能已經成為某個公司用來訓練 AI 演算法的數據集中的一條。

正是眾多不起眼的一條條個人隱私數據,構成了足夠多的訓練集,讓 AI 從中學習到認知能力,讓從未跟我們謀面的 AI 演算法認識、了解我們,知道我們的喜好和動機,甚至還認識我們的家人、朋友。我們的隱私便是實現這些智能的「代價」。

當然,這個代價並不一定是你願意拱手付出的。

那如何保護隱私?我不用行嗎?

你以為關閉手機GPS就無法定位你的位置?你的手機還有陀螺儀、內置羅盤、氣壓計等裝置,還是可以用來定位你的位置。只要使用手機,就不存在絕對的隱私保護。

對於很多手機應用來說,要麼不用,用了就很難避免泄露隱私,比如很多APP必須用手機號註冊,或者需要手機驗證才能繼續使用,還有的需要刷臉驗證等等。那麼,個人想保護隱私能做什麼?什麼也做不了,加上 AI 演算法的黑盒性質,我們甚至對於 AI 背後的邏輯和動機一無所知。

二、監管

隱私保護靠個人防護真的很難實現,需要強有力的法律法規來限制。

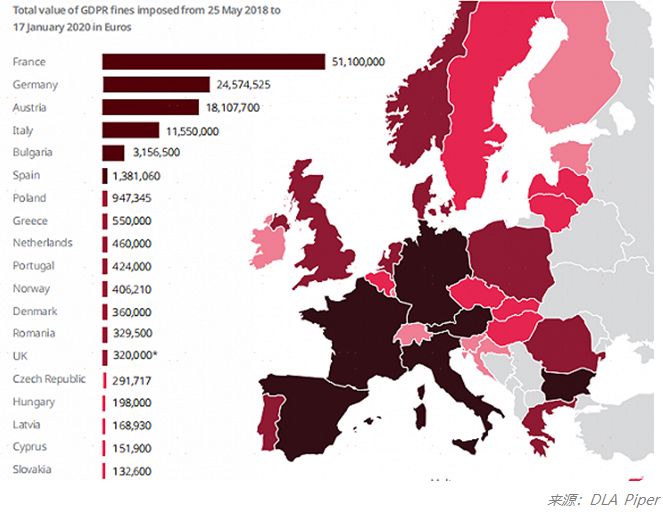

2018年5月25日,歐盟的《通用數據保護條例》(GDPR)正式生效,這是在歐盟範圍內的一個數據保護監管框架,這是目前最完善、最嚴格的隱私保護規定。根據DLA Piper公布的數據,在不到兩年的時間內,GDPR已產生1.14億歐元的罰款,其中開出的最大罰單是法國依據GDPR對谷歌罰款5000萬歐元。

理由是谷歌在向用戶定向發送廣告時缺乏透明度、信息不足,且未獲得用戶有效許可。下圖是GDPR生效以來至2020年1月份歐盟各個國家罰款的金額分布圖。

對於企業,GDPR要求在收集用戶的個人信息之前,必須以「簡潔、透明且易懂的形式,清晰和平白的語言」向用戶說明將收集用戶的哪些信息、收集到的信息將如何進行存儲、存儲的信息將會被如何使用,並告知企業的聯繫方式。

對於個人,GDPR賦予數據主體七項數據權利:知情權、訪問權、修正權、刪除權(被遺忘權)、限制處理權(反對權)、可攜帶權、拒絕權。

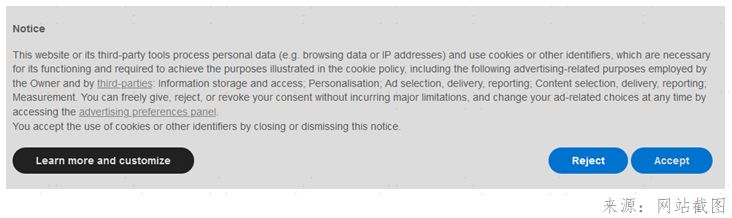

目前GDPR在真實地影響到我們每個人的生活,最直觀的影響就是當你瀏覽網頁的時候,你會發現經常遇到網站彈出類似下圖的提示,這是網站基於信息透明性的規定,向你徵詢信息收集的許可。

歐盟的GDPR具有全球影響力,它讓用戶對自己的個人數據有絕對的掌控權,讓全球在發展新技術的同時必須開始關注隱私問題,世界各國已經紛紛出台自己的數據保護法規。

關於隱私保護,一切才剛剛開始。

歐盟在上個月正式啟動了稱為「打造歐洲數字未來」的新戰略,打算通過制定一系列針對 AI 、隱私和安全的法規,成為 AI 發展的全球領導者。該戰略的啟動也被看成是在應對美國和中國的 AI 崛起。

可以預見,關於 AI 的隱私安全與監管將逐漸成為重點話題,實際上,就像歐盟委員會副主席Margrethe Vestager說的:

「人工智慧本身並沒有好壞之分,而是完全取決於人們為什麼以及如何使用它。讓我們儘可能做到最好,控制人工智慧可能給我們的價值觀帶來的風險——不傷害,不歧視。」

保護隱私已經成為 AI 發展不可繞過的「檻」,是 AI 技術的難題,也是 AI 良性發展的契機。

三、趨勢

可以說,保護隱私的各種法規的出台必然是未來不可避免的趨勢,這勢必讓企業的數據收集、使用及流通的合規成本大幅增加,也容易讓企業內部或者企業間形成數據孤島問題,制約企業獲取數據價值。因此,保護隱私的 AI 技術的落地使用成為 AI 領域最亟待實現的目標。

保護隱私的 AI 主要通過數據加密、分散式計算、邊緣計算、機器學習等多種技術的結合來保護數據安全,近期比較熱門的有Differential Privacy(差分隱私)、FederatedLearning(聯邦學習,也叫聯盟學習、聯合學習、共享學習)。

保護隱私不是說完全不收集數據,而是要通過技術的手段防止個人隱私數據的泄露。

差分隱私是一種數學技術,比如,假設要分析數據集並計算其統計數據(例如數據的平均值、方差、中位數、眾數等),如果通過查看輸出,我們無法分辨原始數據集中是否包含了任何個體的數據,那麼這種演算法就被稱為差異私有。

舉個非常簡單的例子,假設你的工作部門每個月都會用一個表格統計部門每個人的工資發放金額,除了製表人,別人無法查看這個表格,只能通過一個查詢函數S知道這個表的總額。

某個月你調去了別的部門,那麼別人就可以通過上個月表格A,和這個月表格B來知道你的工資,道理很簡單,只需用S(A)減去S(B)。

B表格稱為A表格的相鄰數據集,它倆只相差一條數據,差分隱私技術就是要讓相鄰數據集的查詢結果差不多,從而無法推出個人的信息來,這個差不多的程度可以看作隱私保護的力度。

蘋果和Facebook已經使用這種方法來收集聚合數據,而不需要識別特定的用戶。MITTechnology Review將差分隱私技術列為2020全球十大突破性技術之一。

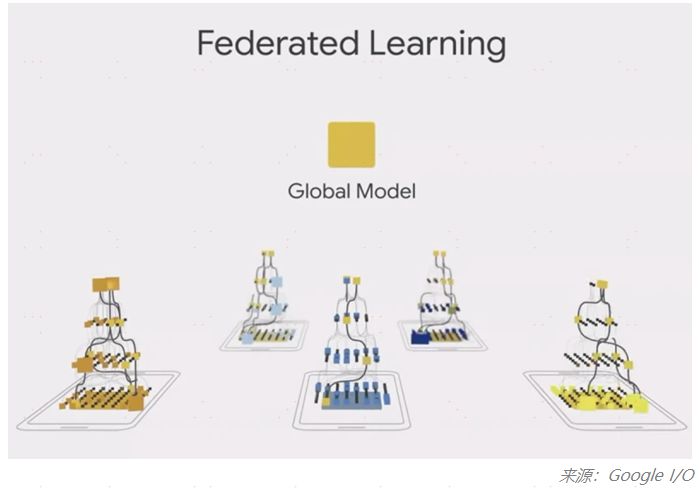

聯邦學習採用了分散式機器學習方法,近年來越來越受歡迎,該技術假設用戶數據不會被存儲到中心化的伺服器,而是私有的、保密的,僅存儲在個人的邊緣設備上,比如手機。

因此與傳統機器學習方法相比,聯邦學習從根本上增強了用戶隱私。聯邦學習不依賴從用戶設備端收集的數據來訓練,而是在用戶移動設備端訓練 AI 模型,然後將訓練得到的參數信息傳輸回一個全局模型,這個過程不需要用戶數據離開個人設備。

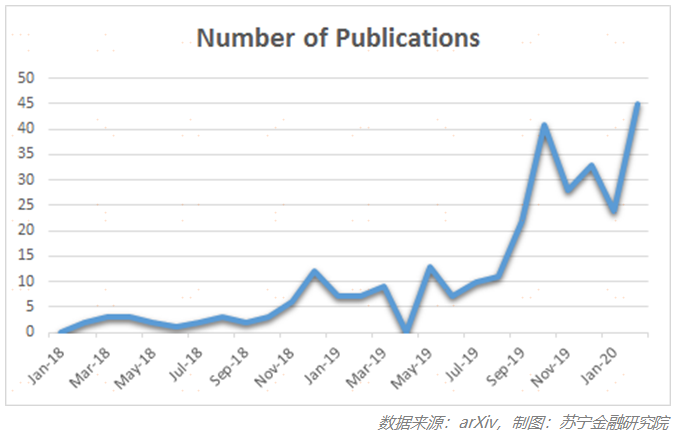

從近兩年在arXiv(一個提交論文預印版的平台)上提交的論文數可以看出,該技術發展的快速趨勢:

四、巨頭的技術布局

從去年起全球最流行的兩個機器學習框架,TensorFlow和PyTorch都增加了聯邦學習等解決方案來保護隱私。

1. Google

聯邦學習的概念最早是由Google在2017年首次引入,去年又發布了TensorFlow Federated(TFF)框架,利用Tensorflow的機器學習框架簡化聯邦學習。

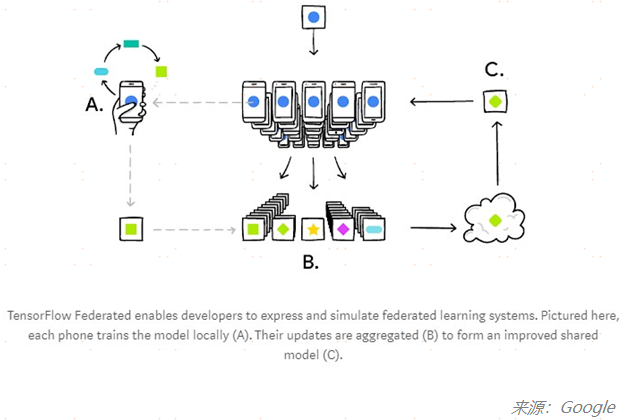

如下圖所示,基於TFF框架搭建的學習模型在眾多手機(如手機A)上進行本地化模型訓練,更新權重並聚合(步驟B),進而更新提升后的全局模型(模型C),將全局模型再應用到各手機終端來提升演算法應用效果。

2. Facebook

為了在保護隱私的機器學習領域取得進展,去年Facebook旗下優秀的深度學習框架PyTorch與OpenMined宣布開發一個聯合平台的計劃,以加速隱私保護技術的研究。

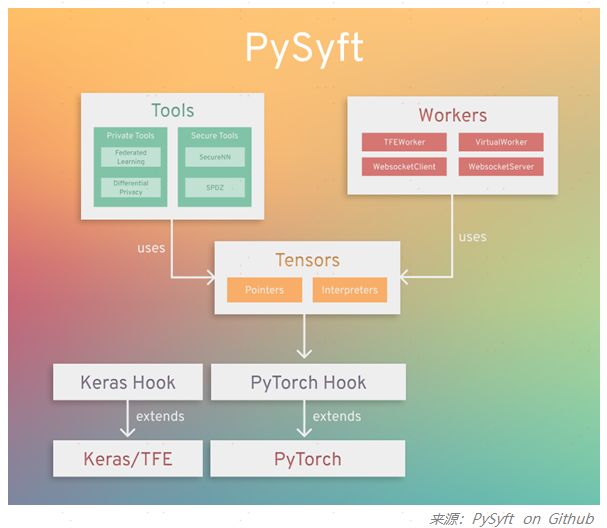

OpenMined是一個開源社區,專註於研究、開發和升級用於安全、保護隱私的 AI 工具。OpenMined發布了PySyft,是第一個用於構建安全和隱私保護的開源聯邦學習框架。

PySyft很受歡迎,在Github已經擁有5.2k個Star,目前支持在主要的深度學習框架(PyTorch、Tensorflow)中用聯邦學習、差分隱私和加密計算(如多方計算,同態加密),實現將隱私數據與模型訓練解耦。

五、國內發展現狀

國內的 AI 巨頭們也早已開啟保護隱私的技術布局,特別是金融領域,金融領域由於監管嚴格,數據的隱私性要求極高,因此,金融機構一方面在保護隱私數據方面面臨技術難題,另一方面由於金融數據的孤立性,「數據孤島」問題導致金融機構無法發揮出數據的真正價值。

國內多家金融機構以及金融科技公司已經嘗試在獲客、授信、風險控制等方面,利用聯邦學習解決數據隱私的合規問題和數據分享的數據孤島問題,最大化的發揮金融數據價值。

目前國內關於保護隱私的監管還不夠成熟,個人和企業對於隱私保護的意識還不強。隨著全球環境中對保護隱私的關注逐漸加強,以及保護隱私的 AI 技術的發展,我相信 AI 技術終究會向著更好的方向發展,希望通過科學家們的努力, AI 的黑盒不會是潘多拉之盒。

作者:李加慶,蘇寧金融研究院研究員;公眾號:蘇寧財富資訊